最近的科学研究表明,在单次20分钟的无人机飞行期间所捕捉到的空中图像可能需要花费半天以上的时间去分析。早些时候为了应对“帕姆”飓风,我们在世界银行的人道主义无人机任务中飞行了几十次。我们捕捉到的图像足以让一位专家分析师专心致志工作至少20个全职工作日才能搞清楚。换句话说,航空影像已经成为一个大数据问题。因此,我和我的团队正在使用人类计算(众包)、机器计算(人工智能)和计算机视觉来理解这一新的大数据源。

例如,我们最近与南安普顿大学和EPFL合作,从航空影像中分析了飓风“帕姆”在瓦努阿图(西南太平洋岛国)中所造成的破坏。这项研究的目的是为了能够得到及时的响应解答。救援组织想要的不仅仅是受灾地区的高分辨率航拍图像,他们需要的是答案;例如,受损建筑物的数量和位置,流离失所的人们的数量和位置,以及还有哪些道路仍然可用来运送救援物资等。简单地给他们图像是远远不够的。正如我在新书《数字人道主义者》中所表明的观点那样,援助和发展组织已经被灾前灾后产生的拥有巨大体量和迅猛速度的大数据所淹没。再加上另一个数据源“空中大数据”可能是毫无意义的,因为这些组织可能根本没有时间和能力来理解这些新数据,更不用说将结果与其他数据集成在一起了。

因此,我们分析了部署用来跟踪飓风帕姆的MicroMappers平台的众包结果,以确定这些数据是否可以用来训练未来能在瓦努阿图遭受灾难的过程中自动检测灾难损害的算法。在整个MicroMappers的部署期间,数字志愿者分析了3000多张高分辨率的倾斜航空图像,追踪那些可能被完全摧毁、部分受损、基本完好的房屋。我和同事Ferda Ofli与Nicolas Rey(暑期和我们共事的EPFL研究生)合作,探索这些痕迹是否可以用来训练我们的算法。下面的结果则出自Ferda和Nicolas之手。我们的研究不仅仅是一项学术活动。瓦努阿图是世界上最易受灾的国家。此外厄尔尼诺现象(El Niño)可能是半个世纪以来最强的一次。

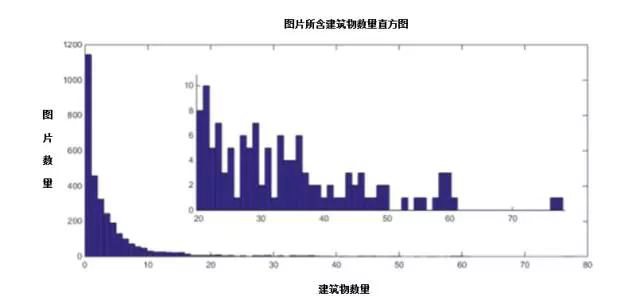

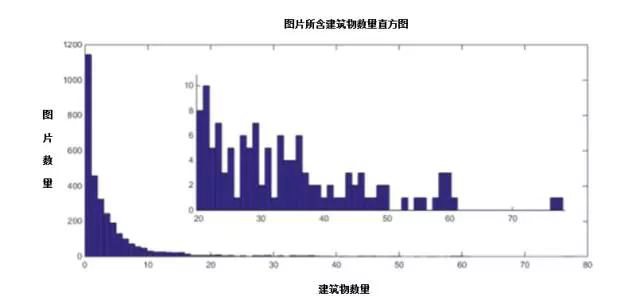

根据众包结果,1145幅高分辨率图像中没有包含任何建筑物。以上是一个简单的直方图,描述每幅图中建筑物的数量。瓦努阿图的航拍图像是非常不均匀的,不仅在它们展示的特征多样性上有所不同,而且在视角和拍摄的高度也各不相同。虽然绝大多数的图像是倾斜的,有些图像几乎是最低点图片,有些则非常接近地面,甚至是在起飞之前拍的。

根据众包结果,1145幅高分辨率图像中没有包含任何建筑物。以上是一个简单的直方图,描述每幅图中建筑物的数量。瓦努阿图的航拍图像是非常不均匀的,不仅在它们展示的特征多样性上有所不同,而且在视角和拍摄的高度也各不相同。虽然绝大多数的图像是倾斜的,有些图像几乎是最低点图片,有些则非常接近地面,甚至是在起飞之前拍的。

我们的图像数据集的异质性使得这种图像的自动分析更加困难。此外,我们数据集中还存在很多尚在施工中的建筑物,因为它们看起来很像损坏的建筑物,所以识别起来也是一个大难题。我们的第一项任务是训练算法,以确定任意给定的航空图像中是否显示了某种建筑物。这是一个重要的任务,因为在我们的数据集中超过30%的图像不包含建筑物。因此,如果我们能够开发出一种精确的算法来自动过滤掉这些无关的图像(比如下面的“噪音”),这样我们就能集中心力于处理相关图像的众包分析。

我们的图像数据集的异质性使得这种图像的自动分析更加困难。此外,我们数据集中还存在很多尚在施工中的建筑物,因为它们看起来很像损坏的建筑物,所以识别起来也是一个大难题。我们的第一项任务是训练算法,以确定任意给定的航空图像中是否显示了某种建筑物。这是一个重要的任务,因为在我们的数据集中超过30%的图像不包含建筑物。因此,如果我们能够开发出一种精确的算法来自动过滤掉这些无关的图像(比如下面的“噪音”),这样我们就能集中心力于处理相关图像的众包分析。

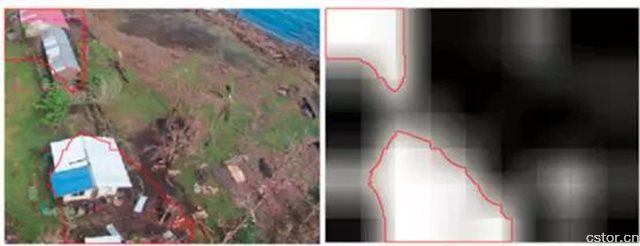

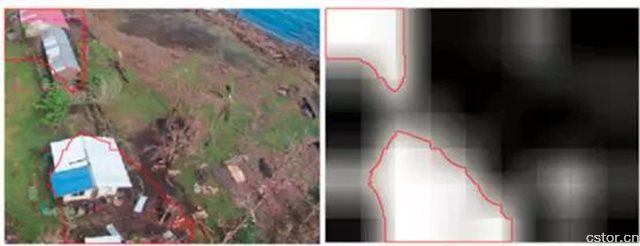

迄今为止虽然我们的研究结果还处于初级阶段,但我们已经对所发现的东西感到欣慰了。我们训练用来确定一幅空中图像中是否包括建筑物的算法已经达到90%以上的精度了。更确切地说,我们的算法能够识别和过滤掉60%不包含任何建筑物(召回率)的图像,而且只有10%包含建筑物的图像被错误地丢弃(精确率为90%)。下面就是举例。毫无疑问现在仍然存在很多的重大挑战,所以我们希望在现阶段不做出过分承诺。在接下来的步骤中,我们将探索我们的计算机视觉算法是否能够区分遭到破坏或者保存完好的建筑物。

我们之前在瓦努阿图使用的无人机还需要我们操作着陆才能获得采集到的图像。现在越来越多的新型无人机提供了实时地将航拍图像和视频传送回基地的功能。例如,大疆推出的“精灵”系列新品Phantom 3无人机(见下图)就允许用户将航空视频直接发送到YouTube进行直播(假设有连接)。毫无疑问,这是无人机工业的发展方向:实时数据收集和分析。在人道主义应用中的搜索和救援等方面,实时进行数据分析是更上一层楼的。

这就解释了为什么我和我的团队最近要与南安普顿大学的Elliot Salisbury & Sarvapali ram进行合作,分析来自灾区的实时航拍视频,并将这种众包和(希望)实时机器学习和自动化特征检测结合起来。换句话说,当数字志愿者忙着在视频中标注灾难损害时,我们希望我们的算法能够实时地向这些志愿者学习。也就是说,我们希望算法能够辨析出灾难破坏的程度,这样他们以后再给定的航空视频中就能自动识别出所遭受的任何灾难。

于是我们最近进行了一项MicroMappers测试部署,使用的是人道主义任务中无人机在瓦努阿图的空中拍摄到的视频。近100名数字志愿者参与了这项部署。他们的任务是什么呢 点击视频中任何显示灾难损坏的地方。当超过80%的志愿者都在点击相同区域时,我们会自动突出显示这些区域,向无人机飞行员和人道主义团队提供近乎实时的反馈。

在模拟过程中,我们有大约30位数字志愿者同时点击了视频区域,平均每秒钟点击12次,并持续5分钟以上。事实上,我们一共点击了49,706次视频!这为MicroMappers提供了足够的实时数据,以作为一种灾难损害评估的人机智能传感器。在准确性方面,整体点击量中有87%的准确率。下面的模拟看起来很像是无人机飞行员,其实只是我们都在点击屏幕。

感谢所有的视频点击,我们得以在无人机还在运行的过程中就导出视频素材中最重要和相关的部分。其中的这些或那些片段再被推送到MicroMappers进行其他验证。这些动画体积小、速度快,将一段长长的空中视频压缩成最重要的镜头。我们现在正在分析被标记的区域,以确定我们是否可以使用这些数据来相应地训练我们的算法。再次强调,这不仅仅是来自学术上的好奇心。如果我们能在接下来的几个月里开发出更加可靠的算法,那么我们就可以在太平洋的下一个台风季节里有效地使用它们。

最后,非常感谢我在QCRI的团队把我的MicroMappers的愿景转化为现实,非常感谢一年前我说我们需要将我们的工作扩展到航空图像的时候他们就如此信任我。如果没有MicroMappers存在,所有上述研究都是不可能的。非常感谢EPFL和南安普顿大学的优秀合作伙伴,他们与我们一起分享愿景,以及他们在我们的联合项目上的辛勤工作。最后,非常感谢来自SBTF及其以外的参与数字人道主义部署数字志愿者。

来源:中国大数据

我们的图像数据集的异质性使得这种图像的自动分析更加困难。此外,我们数据集中还存在很多尚在施工中的建筑物,因为它们看起来很像损坏的建筑物,所以识别起来也是一个大难题。我们的第一项任务是训练算法,以确定任意给定的航空图像中是否显示了某种建筑物。这是一个重要的任务,因为在我们的数据集中超过30%的图像不包含建筑物。因此,如果我们能够开发出一种精确的算法来自动过滤掉这些无关的图像(比如下面的“噪音”),这样我们就能集中心力于处理相关图像的众包分析。

我们的图像数据集的异质性使得这种图像的自动分析更加困难。此外,我们数据集中还存在很多尚在施工中的建筑物,因为它们看起来很像损坏的建筑物,所以识别起来也是一个大难题。我们的第一项任务是训练算法,以确定任意给定的航空图像中是否显示了某种建筑物。这是一个重要的任务,因为在我们的数据集中超过30%的图像不包含建筑物。因此,如果我们能够开发出一种精确的算法来自动过滤掉这些无关的图像(比如下面的“噪音”),这样我们就能集中心力于处理相关图像的众包分析。